Bias Variance

https://biasvariance.net

🌺 کانال تلگرام:

@biasvariance_ir

🌳 پشتیبانی:

@biasvariance

🌷 اینستاگرام:

https://www.instagram.com/bvariance/

?? ??? ?? ????? ?

We comply with Telegram's guidelines:

- No financial advice or scams

- Ethical and legal content only

- Respectful community

Join us for market updates, airdrops, and crypto education!

Last updated 10 months, 2 weeks ago

[ We are not the first, we try to be the best ]

Last updated 1 year ago

FAST MTPROTO PROXIES FOR TELEGRAM

ads : @IR_proxi_sale

Last updated 9 months ago

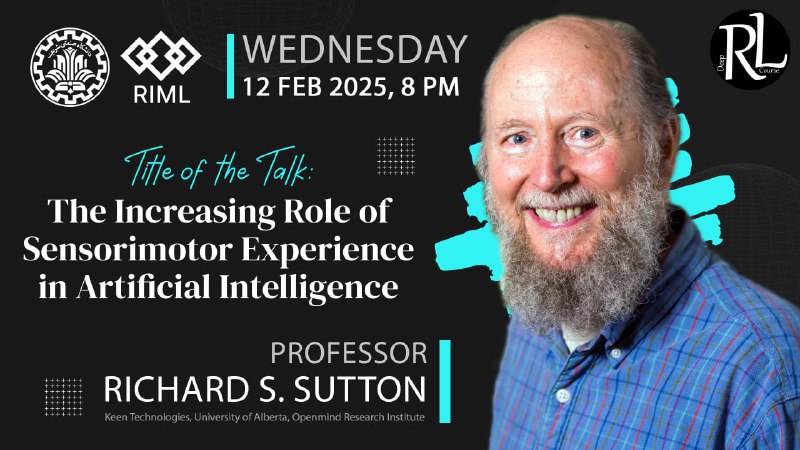

🚀 Join Richard Sutton’s Talk at Sharif University of Technology

*🎙 Title: The Increasing Role of Sensorimotor Experience in Artificial Intelligence

*👨🏫 Speaker: Rich Sutton (Keen Technologies, University of Alberta, OpenMind Research Institute)

📅 Date: Wednesday

🕗 Time: 8 PM Iran Time

💡 Sign Up Here:** https://forms.gle/q1M7qErWvydFxR9m6

شبکههای عصبی عمیق اسپایکینگ

شبکههای عصبی عمیق اسپایکینگ (SNNs) یک پارادایم پیشرفته در معماریهای شبکههای عصبی هستند که از فرآیندهای بیولوژیکی مغز انسان الهام گرفتهاند. بر خلاف شبکههای عصبی عمیق سنتی (DNNs) که از سیگنالهای پیوسته استفاده میکنند، SNNها از رویدادهای گسستهای به نام اسپایکها برای ارتباط استفاده میکنند. در این مقاله به بررسی اصول، مزایا، چالشها و کاربردهای SNNها میپردازیم.

اصول شبکههای عصبی پیکاندار

شبکههای SNN به گونهای طراحی شدهاند که نحوه عملکرد نورونهای بیولوژیکی را تقلید کنند. در سیستمهای بیولوژیکی، نورونها اطلاعات را از طریق پتانسیلهای عمل (اسپایکها یا پیکانها) منتقل میکنند که امواج الکتریکی کوتاهی هستند. این مکانیزم پیکانی اجازه میدهد تا ارتباط و پردازش اطلاعات به طور موثرتری انجام شود. ویژگیهای کلیدی SNNها شامل موارد پایین میشود:

- کدگذاری زمانی: اطلاعات نه تنها با نرخ پیکانها بلکه با زمان دقیق این پیکانها نمایندگی میشود.

- پردازش مبتنی بر رویداد: SNNها تنها زمانی که پیکانها رخ میدهند، اطلاعات را پردازش میکنند که منجر به صرفهجویی در انرژی و زمان پاسخ سریعتر میشود.

- واقعگرایی بیولوژیکی: SNNها ویژگیهایی مانند پلاستیسیته سیناپسی و دینامیکهای زمانی را شامل میشوند که آنها را با شبکههای عصبی بیولوژیکی بیشتر هماهنگ میکند.

مزایای شبکههای عصبی پیکاندار

- کارایی انرژی: SNNها به دلیل الگوهای فیرینگ، firing patterns، پراکنده و طبیعت مبتنیبر رویداد خود، به طور ذاتی از DNNها انرژی کمتری مصرف میکنند. این ویژگی آنها را برای کاربردهایی در سیستمهای موبایل و تعبیهشده که مصرف انرژی مهم است، مناسب میکند.

- پردازش زمان واقعی: طبیعت ناهمزمان ارتباط مبتنی بر پیکان به SNNها اجازه میدهد تا اطلاعات را در زمان واقعی پردازش کنند که برای کاربردهایی مانند رباتیک و وسایل نقلیه خودران ضروری است.

- مقاومت در برابر نویز: طبیعت گسسته پیکانها میتواند SNNها را در برابر نویز در دادههای ورودی مقاومتر کند.

- سازگاری با سختافزارهای نورومورفیک: SNNها میتوانند به طور مؤثری روی چیپهای نورومورفیک که برای تقلید از معماری مغز طراحی شدهاند، پیادهسازی شوند و کارایی آنها را بیشتر کند.

چالشها در آموزش شبکههای عصبی پیکاندار

با وجود مزایا، آموزش SNNها چالشهای قابل توجهی دارد:

- محدودیتهای گرادیان نزولی: روشهای سنتی بهینهسازی که در DNNها استفاده میشود، به دلیل طبیعت غیرقابل تفاضل سیگنالهای پیکانی مستقیماً قابل اعمال بر روی SNNها نیستند. این امر منجر به دشواریهایی در بهینهسازی وزنهای شبکه به طور مؤثر میشود.

- پیچیدگی معماری: طراحی معماری مناسب برای SNNها حیاتی اما چالشبرانگیز است. بسیاری از مدلهای موجود معماریهایی را از DNNها قرض گرفتهاند، اما تطابق مؤثر آنها برای عملکرد بهینه ضروری است.

- عملکرد بر روی مجموعه دادههای بزرگ: اگرچه SNNها در کارایی انرژی تلاشهایی دارند، دقت آنها بر روی مجموعه دادههای بزرگ معمولاً عقبتر از DNNها است که نیازمند تحقیقات و توسعه بیشتر است.

روشهای آموزشی برای شبکههای عصبی پیکاندار

چندین رویکرد برای آموزش SNNها توسعه یافته است:

- آموزش مستقیم: شامل آموزش SNNها با استفاده از روشهایی مانند پلاستیسیته وابسته به زمان پیکان (STDP) یا آموزش محدود قبل از تبدیل از یک مدل DNN است.

- تبدیل از DNNها: DNNهای پیشآموزش دیده میتوانند به مدلهای SNN تبدیل شوند با تطابق وزنها و پارامترهای آنها برای تناسب با چارچوب پیکانی. این روش نشان داده است که عملکرد مناسبی دارد.

- الگوریتمهای الهام گرفته از بیولوژی: الگوریتمهای جدیدی که فرآیندهای یادگیری بیولوژیکی را تقلید میکنند در حال بررسی هستند تا کارایی و اثربخشی آموزش SNNها را افزایش دهند.

کاربردهای شبکههای عصبی پیکاندار

شبکههای SNN دارای دامنه وسیعی از کاربردها در زمینههای مختلف هستند:

- بینایی کامپیوتری: برای وظایفی مانند شناسایی اشیا و درک صحنه، به ویژه با سنسورهای بینایی مبتنی بر رویداد که دادهها را به صورت فرمت پیکانی خروجی میدهند، استفاده میشوند.

- رباتیک: در سیستمهای رباتیکی، SNNها تصمیمگیری زمان واقعی و یادگیری تطبیقی مبتنیبر ورودیهای حسی را تسهیل میکنند.

- محاسبات نورومورفیک: با ظهور سکوهای سختافزاری نورومورفیک، SNNها به طور فزایندهای برای توسعه سیستمهای هوشمند که نیازمند مصرف کم انرژی و سرعت پردازش بالا هستند، مرتبط میشوند.

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

#مقاله #یادگیری_عمیق #spiking_neural_networks #شبکه_عصبی

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

پشتیبانی | کانال | سایت | اینستاگرام | آپارات

استفاده از RAG در یادگیری عمیق: ترکیب بازیابی اطلاعات و تولید متن

مدلهای Retrieval-Augmented Generation (RAG) یکی از پیشرفتهای اخیر در حوزه پردازش زبان طبیعی و یادگیری عمیق است که توانایی مدلهای زبانی بزرگ (LLM) را با قدرت بازیابی اطلاعات ترکیب میکند. این رویکرد به مدلها اجازه میدهد تا پاسخهای دقیقتر، بهروزتر و قابل اعتمادتری تولید کنند.

مفهوم اصلی RAG

مدل RAG از دو بخش اصلی تشکیل شده است. بخش بازیابی (Retrieval) که اطلاعات مرتبط را از منابع خارجی بازیابی میکند و بخش تولید (Generation) که از یک مدل زبانی برای تولید پاسخ با استفاده از اطلاعات بازیابی شده استفاده میکند. این رویکرد به مدلها اجازه میدهد تا به جای اتکا صرف به دانش ذاتی خود، از منابع خارجی برای پاسخگویی استفاده کنند.

مزایای استفاده از RAG

- دقت بالاتر: با استفاده از منابع خارجی، مدل میتواند اطلاعات دقیقتر و بهروزتری ارائه دهد.

- شفافیت: منابع استفاده شده قابل ردیابی هستند، که به افزایش اعتماد کاربران کمک میکند.

- بهروزرسانی آسان: اطلاعات جدید را میتوان بدون نیاز به بازآموزی کامل مدل اضافه کرد.

- کاهش خطای توهم: احتمال تولید اطلاعات نادرست توسط مدل کاهش مییابد.

نحوه عملکرد RAG

- دریافت پرسش: سیستم پرسش کاربر را دریافت میکند.

- بازیابی اطلاعات: با استفاده از تکنیکهای بازیابی اطلاعات، منابع مرتبط از پایگاه داده بازیابی میشوند.

- ترکیب اطلاعات: اطلاعات بازیابی شده با پرسش اصلی ترکیب میشوند.

- تولید پاسخ: مدل زبانی با استفاده از اطلاعات ترکیب شده، پاسخ نهایی را تولید میکند.

چالشهای RAG

- انتخاب منابع مناسب: انتخاب و مدیریت منابع اطلاعاتی مناسب و بهروز چالشبرانگیز است.

- هماهنگی بین بازیابی و تولید: ایجاد تعادل بین دقت بازیابی و کیفیت تولید متن مهم است.

- مدیریت حجم داده: با افزایش حجم دادهها، مدیریت و بازیابی سریع اطلاعات پیچیدهتر میشود.

کاربردهای RAG در یادگیری عمیق

- سیستمهای پرسش و پاسخ: برای ارائه پاسخهای دقیقتر به سوالات کاربران.

- چتباتهای هوشمند: برای بهبود توانایی چتباتها در ارائه اطلاعات دقیق و بهروز.

- خلاصهسازی متون: برای تولید خلاصههای دقیقتر با استناد به منابع اصلی.

- تولید محتوا: برای ایجاد محتوای غنیتر و مستندتر در حوزههای مختلف.

پیادهسازی RAG

برای پیادهسازی RAG، معمولاً از ترکیب چند تکنولوژی استفاده میشود:

- پایگاه داده برداری: برای ذخیره و بازیابی سریع اطلاعات.

- مدلهای Embedding: برای تبدیل متن به بردارهای عددی قابل جستجو.

- الگوریتمهای بازیابی اطلاعات: مانند روش Approximate Nearest Neighbor (ANN) برای یافتن مرتبطترین اطلاعات.

- مدلهای زبانی بزرگ: مانند GPT یا BERT برای تولید متن نهایی.

مثالهایی از کاربرد RAG در دنیای واقعی

- سیستمهای پشتیبانی مشتری: برای ارائه پاسخهای دقیق و سازگار با سیاستهای شرکت.

- موتورهای جستجوی پیشرفته: برای ارائه نتایج جستجوی غنیتر و مرتبطتر.

- سیستمهای آموزشی هوشمند: برای ارائه توضیحات شخصیسازی شده به دانشآموزان.

- ابزارهای تحقیق و توسعه: برای کمک به محققان در یافتن و ترکیب اطلاعات از منابع مختلف.

آینده RAG

با پیشرفت فناوری، انتظار میرود که RAG در آینده توسعه بیشتری یابد که میتوان به موارد زیر اشاره کرد.

- بهبود الگوریتمهای بازیابی: برای یافتن دقیقتر و سریعتر اطلاعات مرتبط.

- ترکیب با سایر تکنیکهای هوش مصنوعی: مانند یادگیری تقویتی برای بهبود عملکرد.

- گسترش به حوزههای چندرسانهای: استفاده از RAG برای تحلیل و تولید محتوای تصویری و صوتی.

- بهبود مقیاسپذیری: برای استفاده در سیستمهای بزرگتر با حجم داده بیشتر.

روش RAG یک گام مهم در توسعه سیستمهای هوش مصنوعی است که توانایی مدلهای زبانی را با قدرت بازیابی اطلاعات ترکیب میکند. این رویکرد نه تنها دقت و اعتبار پاسخهای تولید شده را افزایش میدهد، بلکه امکان بهروزرسانی مداوم دانش سیستم را نیز فراهم میکند. با ادامه پیشرفتها در این زمینه، انتظار میرود که RAG نقش مهمی در آینده پردازش زبان طبیعی و یادگیری عمیق ایفا کند.

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

#مقاله #یادگیری_عمیق #RAG #شبکه_عصبی

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

پشتیبانی | کانال | سایت | اینستاگرام | آپارات

معمولا بدلیل اینکه بچههای هوش بیشتر مقالات و کتابها را بررسی میکنند، ضعف در listening انگلیسی دارند. یکی از قابلیتهای chrome این است که میتوان در آن فایلهای ویدیوی لوکال را با زیرنویس دید. برای این منظور لازم است ویدیوی لوکال را در chrome باز کنید که با درگ اند دراپ یا فایل اکسپلورر کروم قابل انجام است. در ادامه لازم است یکبار تنظیماتی که ذکر میکنیم را انجام دهید تا زیرنویس به صورت لایو تولید شود. به صورت دقیقتر کروم دارای یک ویژگی داخلی به نام زیرنویس زنده است که به طور خودکار برای رسانههای دارای صدا، زیرنویس تولید میکند.

نحوه فعالسازی:

به تنظیمات کروم بروید.

روی بخش Advanced کلیک کنید، سپس به Accessibility بروید.

گزینه Live Caption را فعال کنید. ?

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

#مقاله

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

پشتیبانی | کانال | سایت | اینستاگرام | آپارات

راهنمایی در مورد هستههای CUDA و حافظهی ویدیویی (VRAM)

هستههای کودا، واحدهای پردازشی موازی در کارتهای گرافیک انویدیا هستند که برای محاسبات عمومی طراحی شدهاند. این هستهها قادرند چندین وظیفه را به طور همزمان انجام دهند و برای پردازش موازی بهینه شدهاند.

حافظه ویدیویی یا VRAM، حافظه اختصاصی پرسرعتی است که توسط کارت گرافیک استفاده میشود. این حافظه دادههای مربوط به گرافیک را به طور موقت ذخیره میکند و ظرفیت آن بر توانایی کارت گرافیک در پردازش تأثیر میگذارد.

ارتباط بین هستههای CUDA و VRAM

هستههای کودا و حافظه ویدیویی هر دو برای عملکرد کارت گرافیک مهم هستند، اما ارتباط مستقیمی از نظر اندازه یا تعداد ندارند. هستههای کودا دادهها را پردازش میکنند، در حالی که حافظه ویدیویی آنها را ذخیره میکند. عملکرد بهینه کارت گرافیک به تعادل مناسب بین این دو عنصر بستگی دارد و این تعادل بر اساس نوع کاربرد متفاوت است. در اینجا نحوه تعامل آنها را شرح میدهیم:

-

عملکرد مکمل: هستههای CUDA دادهها را پردازش میکنند، در حالی که VRAM آنها را ذخیره میکند. تعداد بیشتر هستههای CUDA میتواند دادهها را سریعتر پردازش کند، اما آنها نیاز به VRAM کافی برای نگهداری دادهها دارند.

-

تعادل عملکرد: کارت گرافیکی با تعداد زیادی هسته CUDA اما VRAM محدود ممکن است در وظایفی که نیاز به دادههای زیادی دارند دچار مشکل شود، در حالی که کارت گرافیکی با VRAM زیاد اما هستههای CUDA کم ممکن است دادههای بیشتری را ذخیره کند اما آنها را کندتر پردازش کند.

-

اهمیت وابسته به وظیفه: برای برخی وظایف، مانند کار با مدلهای بزرگ یادگیری عمیق، داشتن VRAM بیشتر ممکن است مهمتر از داشتن هستههای CUDA بیشتر باشد.

-

مقیاسپذیری: به طور کلی، کارتهای گرافیک پیشرفتهتر تمایل دارند که هم هستههای CUDA بیشتر و هم VRAM بیشتری داشته باشند، اما نسبت بین آنها ثابت نیست و بین مدلها و نسلهای مختلف کارت گرافیک متفاوت است.

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

#مقاله #یادگیری_عمیق #شبکه_عصبی

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

پشتیبانی | کانال | سایت | اینستاگرام | آپارات

مقالهی KAN اخیرا بسیار سروصدا کرده و خواندن آن را به شدت توصیه میکنیم. این زمینه را برای موضوع دکتری توصیه میکنیم.

Inspired by the Kolmogorov-Arnold representation theorem, we propose Kolmogorov-Arnold Networks (KANs) as promising alternatives to Multi-Layer Perceptrons (MLPs). While MLPs have fixed activation functions on nodes (“neurons”), KANs have learnable activation functions on edges (“weights”). KANs have no linear weights at all – every weight parameter is replaced by a univariate function parametrized as a spline. We show that this seemingly simple change makes KANs outperform MLPs in terms of accuracy and interpretability. For accuracy, much smaller KANs can achieve comparable or better accuracy than much larger MLPs in data fitting and PDE solving. Theoretically and empirically, KANs possess faster neural scaling laws than MLPs. For interpretability, KANs can be intuitively visualized and can easily interact with human users. Through two examples in mathematics and physics, KANs are shown to be useful “collaborators” helping scientists (re)discover mathematical and physical laws. In summary, KANs are promising alternatives for MLPs, opening opportunities for further improving today’s deep learning models which rely heavily on MLPs.

https://arxiv.org/html/2404.19756v1

ــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

#معرفی_مقاله #معرفی_منبع #یادگیری_عمیق #شبکه_عصبی

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

پشتیبانی | کانال | سایت | اینستاگرام | آپارات

Call for Papers

Call for Papers

Transformer-based models have emerged as a cornerstone of modern artificial intelligence (AI), reshaping the landscape of machine learning and driving unprecedented progress in a myriad of tasks. Originating from the domain of natural language processing, transformers have transcended their initial applications to become ubiquitous across diverse fields including anomaly detection, computer vision, speech recognition, recommender systems, question answering, robotics, healthcare, education, and more. The impact of transformer models extends far beyond their technical intricacies. For instance, advanced transformers have been successfully applied to multimodal learning tasks, where they can seamlessly integrate information from different modalities such as text, images, audio, and video. This ability opens up new avenues for research in areas like visual question answering, image captioning, and video understanding.

https://dl.acm.org/pb-assets/static_journal_pages/tist/pdf/ACM-TIST-CFP-SI-Transformers.pdf

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

#اطلاع_رسانی

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

پشتیبانی | کانال | سایت | اینستاگرام | آپارات

سلام، بعد از مدتی دوری و رخدادن اتفاقات مختلف، مجدد مطالبی را ذکر میکنیم و به روال عادی بازمیگردیم و برای مدتی طولانی در مورد پالتیک حرف نمیزنیم. اول از همه به اللکششن یو اس اشاره میکنیم که چندماه دیگر برگزار میشود و پس از دراپشدن مشکوک چاپر پریویس پرزیدنت آیرون، بالاخره ما با اونها کووردینیت شدیم. اول از همه چندتا پیشبینی میکنیم با توجه به شرایط فعلی اینجا و اونجا. اگر به خاطر داشتهباشید، چهار سال پیش شانس صنننندددرز در کندیدیتی بسیار بیشتر از فایدن بود ولی بدلیل یکی از اظهاراتش که اشاره کرده بود باید جنیساید در پالاستین به پایان برسد و مستقلشوند، شانسش را کاملا از دستداد. در حال حاضر همانطور که شاید بدانید شانس توروپ خیلی زیاد است و استیتهای سوینگگ ووتشان به سمت قرمزها برگشته و تقابل مجدد چپیهای آیرون با راستیهای یو اس مجدد شکل خواهد گرفت. هرچند بعید است ولی لازم است اشاره کنیم که حریص (!) هم فرد بهشدت هاردلاینری نظیر لیدی چیلینتون است. بدلیل نشنالیتیی همسرش هم وابسته به ز ااا! یونیس ها است. در این مدت اتفاقات مختلفی افتاد که بسیار سخت است به همه پرداخته شود ولی به مواردی اشاره میکنیم. در جایی که بچههای یعقوپ برای خود برداشتهاند، اوضاع ناآرام است و احتمالا بدانید که آن ناحیه برای جو ییش پیپل، کریسچنها و زالونیستها بسیار مقدس است. با توجه به اتفاقاتی که رخداده دو احتمال وجود دارد. شعاع وار افزایش پیداکند یا اینکه بورد فعلی جاهو کلهپا شود و مثل سالها قبل که شششاارون کیلر جنگی شناخته شد، تمامی تقصیرها روی جاهو حواله شوند و ملت همیشه مظلوم زالونیست مظلومتر شناخته شوند. چند هشدار میدهیم زیرا از نفوذشاین در آیرون خبر داریم. اعتقادی زالونیستها دارند و آن این است که همه جز خودشان حیوان هستند و به همین دلیل بهراحتی کودک کیل میکنند. در همین یو اسش هم که با چندتاشون صحبت که کردهبودیم که این بایاس مغزی بهشدت ریشیست است با کمال تعجب با جواب یکسان گاد اینطور خواسته روبهرو شدیم. برامون جالبه که اگر عحد اطیغغه را خوانده باشید جایی هست که همون گاد با جی کوب پرافیت کشتی میگیره و میبازه. به هر حال اشاره میکنیم. دوسال پیش که همه رو توی آیرون توی جون هم انداختند را به خاطر بیاورید. ایمیجی که از مرحوم امم ین یی منتشر شد را ریپرتر نیوزپیپر شرقی در اآیرون منتشر کرد. باس این نیوزپیپر سابقا فامیلیش کهن بوده بعد عوض کرده. ادامه نمیدیم خودتون برید ببینید کیه. این که دیده میشه در اونجا جناب بیوتیفول کلام از پرچم مثلثهای متقاطع میپره بدانید که منفعتی داره و کورکورانه قبول نکنید. اگر اونجا دستار به سرها کچلتون کردن با مواردی اینجا هم دقیقا با مظلومیت و گوگولی مگولی بودن قوم جیکوب کچل کردن همه رو. هر چی هم جنساید شه به ورلد وار قبلی اشاره میشه. پیش بینی میکنیم ماسک گنبد سبزه که اولین سمت نما ز بود رو خودشون بزنن و به جاش حیییکل سولومون رو درست کنن و توی اون اگر فرصت کنند گیت معروفشون رو راه بندازن که محل ورودی ... است. مورد بعدی که اشاره میکنیم اینکه دث پرزیدنت به شدت مشکوک بود. جدای اینکه اون فرد قرار بود لیدر فیوچر آیرون باشه، تاریخی که اون اتفاق افتاد توی سری انیمیشنی کد شده بود و جناب ماسک هم تووییت مشکوکی زده بود قبلتر. کسانی که قبلهشون جناب ماسک هستش لازمه یک نکتهای رو بدونن که بی خود نمیآ د در مورد آیرون افاضات کنه. حتما این مورد را بررسی کنید. صاحب تسلا چند سال پیش سرمایهگذاری کرد که یکی از کانتریهای اومریکای چنوبی سقوط کنه چون یکی از بزرگترین ذخایر معدنی رو داشت که ماسک در تسلا به آن نیاز داشت. بعد از اینکه کلهپا کردن، جناب توییت ززدن با این مضمون که هرکاری بخوام باهاتون میکنم. حالا کانتری آیرون که بیشترین اویل و گز یونیورس رو داره، محل اتصال سه کانتیننت به هم هستش چون بالا پایینش دریاست و وسعت زیادی داره و از همه مهمتر زالونیستتها مثل سگ میترسن ازش چون توی پیشگویییهای بوکشون اومده که با ما دیستروی میشن مثل یه خار توی چشمشون هستش. از اون جایی که هیچکی تاریخ نمیخونه تو آیرون برید ببینید و بگرددید چطوری آیرن کوچیک شدش. چرا مونگولها یا اسکاندر به آیرون اتک زدن. از اون نهنگ میخواستن کاری کنن که سوسک هم نمونه چه برسه به گربه. پروفسور ناصر سیبیل که یه کله کل افگانستان را داد رفت کمی جغرافیا نمیدانست که ببینید اونجا با چاینا بوردر مشترک دارد. همین حالا میگوییم. هدف کلا پول هستش. قرار است پاور از قرروب جغرافیا به شرووغ جوقراقیا برود و چاینا به آیرون برای راه زمینی نیاز دارد. به همین خاطر دو سال پیش نه تنها آیرون بلکه کل مسیر رود افریشم از داخل به هم پاشیده بودند. وسعت آیرون دلیل اصلی این بود که چرج جوش به آیرون اتک نزد بیست سال قبل. نمیدانیم. شاید بعدها بیشتر نوشتیم.

ــــــــــ

#نیوز

معمولا یکی از ضعفهای بسیاری از دانشجویان در مواجه با مفاهیم یادگیری، عدم توانایی در تصور محاسبات در جبر خطی است. یکی از وبسایتهای جالبی که در این حوزه وجود دارد و درک عمیقی از محاسبات جبری ارایه میدهد، وبسایت MathIsFun است که بخشهای متنوع فراوانی دارد. برای مثال در این لینک نویسندگان جدای از محاسبات، درک بصری روشنی از انجام ضربداخلی ارایه کردهاند. اما مطالب این وبسایت به اینجا ختم نمیشود. میتوانید مطالب متنوعی نظیر نظریهی بازیها و مطالبی مشابه را نیز به روشهای جالب این وبسایت فرابگیرید.

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

#معرفی_وبسایت #معرفی_منبع

ـــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــــ

پشتیبانی | کانال | سایت | اینستاگرام | آپارات

Mathsisfun

Dot Product

A vector has magnitude (how long it is) and direction ... Here are two vectors

?? ??? ?? ????? ?

We comply with Telegram's guidelines:

- No financial advice or scams

- Ethical and legal content only

- Respectful community

Join us for market updates, airdrops, and crypto education!

Last updated 10 months, 2 weeks ago

[ We are not the first, we try to be the best ]

Last updated 1 year ago

FAST MTPROTO PROXIES FOR TELEGRAM

ads : @IR_proxi_sale

Last updated 9 months ago