Data Blog

P.S. Да, автор — кошатник 🐈

Для тех, кто любит IT и мемы;

Админ, сотрудничество: @skill8989

Канал на бирже: telega.in/c/programmer_memes_tg

Предложка мемов – @sendmeapic_bot

Чат канала – @programmer_chatt

Last updated 2 days, 11 hours ago

• مرحبًا بك في بوت تمويل العرب

———

~ افضل بوت تمويل حقيقي في العالم

~ رابط البوت ↫ t.me/xnsex21bot .

———

• المطور الرسمي : @zzz_z 👨🏻💻.

Last updated 2 months, 3 weeks ago

Multi Level Test Best Preparation

Owner: @Nozimjon_Mamadaliev

Ads: @Ads_infochannel

Results: @Students_Resultss

Last updated 2 months, 1 week ago

Привет, друзья!

Пока дата-автор в дата-завале, предлагаю вам дата-задачку! 🤟🏻

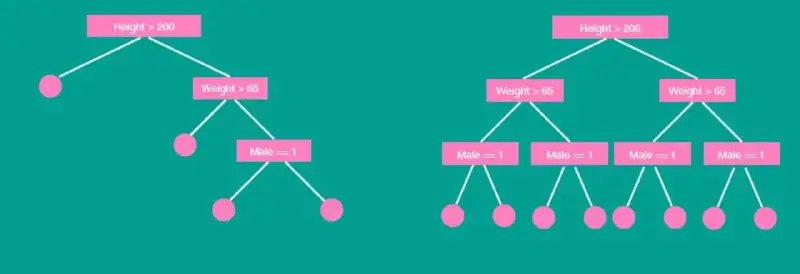

*Пусть вы решили задачу несколькими деревьями решений с сопоставимым качеством. Чтобы выбрать лучшее, вы решили визуализировать и сравнить их структуры и заметили две разных ситуации (см. рис. 1).

Какому дереву следует отдать предпочтение и почему?*

Привет, друзья! Поговорим про XRL? 🤓

Что это:

XRL — Explainable Reinforcement Learning — дословно объяснимое обучение с подкреплением — подобласть объяснимого искусственного интеллекта в целом.

🧷Основные подходы области

Декомпозированы, как и сам процесс обучения с подкреплением, на 4 основных подхода:

- model-explaining — объяснение модели,

- reward-explaining — объяснение вознаграждения,

- state-explaining — объяснение состояния,

- task-explaining methods – объяснение задачи.

*🦥Два суб-подхода основных подходов:*

- self-explainable

- explanation-generating

В чём отличие:

Self-explainable — модели, призванные быть понятными при обучении. Базовый тип таких — деревья решений или просто логические правила.

Explanation-generating — модели, которые «за своё слово отвечают», генерируя объяснения. Пример — контрактные объяснения — к прогнозу генерируем ближайший прогноз противоположного класса.

*🫡Как контролировать этот зоопарк?*

Создавая бенчмарки — ориентиры по качеству. Пример такого XRL-Bench (репозиторий)

На что обратить внимание:

Если вы давно наблюдаете за постами, то можете заметить частоту, с которой встречается метод объяснения SHAP — здесь он не исключение. Вместо вывода — рекомендация — его понимание, уверена, войдет в джентельменсткий набор!

Вместо заключения — как всегда с припиской,

Желающий быть тюльпаном, а не человеком,

Вносящий правки в научно-технический отчет (о, это достойно отдельного поста),

Всё ещё ваш,

Дата-автор!

Доброго воскресного, друзья!

Вы хороши! Спасибо каждому, кто тыкнул в опросе! 🤌🏻

Разберем верный ответ.

Ошибка модели может быть разложена на три компоненты: дисперсию, смещение и шум, при допущении о том, что:

- Шум в данных незначителен и имеет нормальное распределение со средним 0

И при условиях, что:

- мы рассматриваем в качестве ошибки Mean Squarred Error.

Про другие варианты:

Почему MSE/MAE/Logloss и вообще любые функции некорректно рассматривать вместе?

- Потому что они имеют разное аналитическое разложение — эта причина в целом покрывает пункты 1, 2, 4.

Чем так хороша MSE? 🤔

Аккуратное математическое разложение, по такой родной и знакомой формуле (a-b)^2 = a^2 - 2ab + b^2.

Стоит ли тогда рвать отношения с MAE/logloss и тд? ☹️

Нет конечно! Исследователи не спят и исследуют возможные разложения других функций. Для любителей зарыться ссылки ниже =)

Какое место у анализа bias-variance-decomposition в XAI? 👀

Разложение ошибки дает возможность понять генеральное поведение модели на всех данных. И чем лучше «чувствуется», насколько модель может "стрельнуть мимо" — тем лучше.

Ссылки для читающих:

1. Смотреть полное разложение для MSE

2. Разложение MAE на ошибки смещения, пропорциональности и несистематическую

3. Другое обобщение разложения

*🍒 И самое вкусное:*

4. Bias-Varince-Decomposition чтобы использовать ручками (кстати, не только для mse, но и для 0-1 loss)

Анализируйте свои модели, пейте вкусный кофе и сохраняйте тепло!

Со всем самым добрым,

Ждущий огоньков, если продолжаем и желающий вам чудесного дня, Ваш Дата-автор!

Привет, друзья!

Сегодня с нами дата-задача. 🤌🏻

Из теории известно, что ошибка модели может быть разложена на три компоненты: дисперсию, смещение и шум.

Внимание, вопрос:

“Объяснимый искусственный интеллект” через призму задачи тематического моделирования.

Привет, друзья! Я активно продолжаю заниматься своей задачей и эти новогодние выходные закончила разметкой корпуса с 4698-ю статьями, собранных по ключевому слову “Explainable AI” с ресурса pubmed.

🧷 Разметка была простая, как овсянка — 0 — если статья принадлежит теме, и 1 — если статья теме не принадлежит. Также у меня был собран (по тому же ключу) набор данных с ресурса arxiv. И итого была получена 6471-а статья, где около 1756 принадлежат теме “Expainable AI”. Собирались, что ещё важно, названия и аннотации статей.

Анализ области XAI как бы “сверху” представляет собой сложную задачу, но занудные объяснения “почему” я оставлю для научрука и тех, кто будет читать мой диплом.

Вам же хочу рассказать в целом об идее — оценить тему при помощи разбиения её на подтемы.

Приведенная задача представляет собой пример из кластерного анализа, относящегося к обучению без учителя. (Когда размечать 1756 статей на подтемы лень) 😁

Основная сложность здесь: изначальная не независимость статей. Они уже были выбраны по конкретному ключу и уже содержали большое количество специфически одинаковых слов.

Поскольку в NLP я — как гриб без шляпки, к своей реализации идеи я пошла практическим путем, успела “потрогать” два метода:

LDA (Latent Dirichlet allocation) — скрытое размещение Дирихле, вероятностный метод, базирующийся на условной вероятности.

BERTopic — метод тематического моделирования, который для создания кластеров использует эмбеддинги BERTа и TF-IDF.

Основные выводы:

1. Метод LDA хуже справился с задачей выделения каких-либо сколь угодно понятных тем. Я думаю, это связано с однородностью датасета и изначальной зависимостью документов между собой.

2. Моделирование при помощи BERT, среди двух, оказалось более сильным методом, и в дальнейшем, его хорошо использовать как минимум для проверки гипотезы о возможности разбить тему на подтемы.

Выводы про XAI:

- На основе 1756 статей мне удалось выделить 3 кластера:

"Метод" (статьи, описывающие какой-либо метод интерпретации/объяснения);

"Применение" (статьи, где методы интепретации и объяснения используются для анализа модели);

"Доверие и право" (статьи, где XAI появляется вместе с этическими/юридическими вопросами).

Такие вот дела! На деле попутно ужасно переживаю по грантовому проекту, так как пока самый практически полезный результат — таблица с фреймворками. 🫠

Думаю, потом задеплою её как-нибудь. И продолжаю работать!

Дайте знать, если пост был для вас интересен!) 🔥

Надеюсь, вы уже вошли в хороший рабочий ритм,

Ваш Дата-автор!

Доброго вам вечера, друзья!

Пишу поздравить вас с Новым годом! 🎄🎨

Поздравляю искренне, и как могу шлю вам теплоту и доброту в этот вечер.

Год был сложным. У каждого в своём.

Этот вечер тоже может быть не простым. Не праздничным.

Но я всё же невероятно желаю вам улыбнуться!

Вы не одни. Мы — здесь.

У вас всё получится. Чудеса, результаты работы в ночи, новые возможности и то самое "второе дыхание", если вдруг накрыло состояние "всё" — они в вас.

И пусть в новом году внутри вас всегда будет место радости и доброте! 🫶🏻

Сегодня объевшись мандаринов,

Ваш Дата-автор! 🍊🐷

Привет, друзья! Today I want to tell you a story about the paper "Tell Me a Story! Narrative-Driven XAI with Large Language Models" 🤡

Что: В статье предложены CFstories, SHAPstories и XAIstories — объяснения на основе методов Shapley values и Counterfactual explanations соответственно.

Зачем это: дело в том, что значения Шеппли выдают изображение с коэфициентами, а контрфактические объяснения (для классификации изображений) — сегмент картинки, который нужно заблюрить, чтобы получить некорректный прогноз от модели. Заблюренный сегмент не дает понятного ответа на вопрос "почему именно этот сегмент?", а коэффициенты, получаемые при помощи значений Шеппли нетривиально понять.

Решение: Авторы натренировали LLM разъяснять на естественном языке объяснения, получаемые при помощи обозначенных методов.

Промты и результаты смотрите в статье! Меня очень впечатлило всё — и идея, и качество 🤌🏻

Библиотеки для интерпретации глубоких моделей.

Привет, друзья!

Делаю еженедельный чёс по свежим статьям и вот нашла подборку свежих библиотек для интерпретации трансформеров и других глубоких моделей.

🐮 1. Captum — библиотека, с широким набором методов интерпретации для разных уровней детализации — на уровне признаков, слоев или нейронов. Второй плюс библиотеки — мультимодальность относительно данных — можно интерпретировать сети, обученные на изображениях, текстах, аудио или видео.

🐷 2. AttentionViz — библиотека, чьим преимуществом является визуализация во всех возможных плоскостях именно механизма внимания трансформеров. Посмотрите, как это красиво!

🐏 3. Quantus — библиотека, дающая ответ на вопрос о возможности измерения качества полученного объяснения. Пока из всех, встреченных мною, эта библиотека — первая с таким функционалом! 🔥

Как говорится, сохраняем, делимся, ставим огонёчки, друзья! И как всегда — отличного вам продолжения недели!

Не мерзните и не перерабатывайте,

Ваш Дата-автор!

Для тех, кто любит IT и мемы;

Админ, сотрудничество: @skill8989

Канал на бирже: telega.in/c/programmer_memes_tg

Предложка мемов – @sendmeapic_bot

Чат канала – @programmer_chatt

Last updated 2 days, 11 hours ago

• مرحبًا بك في بوت تمويل العرب

———

~ افضل بوت تمويل حقيقي في العالم

~ رابط البوت ↫ t.me/xnsex21bot .

———

• المطور الرسمي : @zzz_z 👨🏻💻.

Last updated 2 months, 3 weeks ago

Multi Level Test Best Preparation

Owner: @Nozimjon_Mamadaliev

Ads: @Ads_infochannel

Results: @Students_Resultss

Last updated 2 months, 1 week ago