Big Data AI

Вопросы с собеседований по Machine Learning, Data Science, Deep Learning и Нейроннным сетям

@data_analysis_ml - анализ данных

@ai_machinelearning_big_data

@itchannels_telegram - важное для программиста

Бизнес блог #1

Выжимаю книги до самой сути.

👉 Реклама - @jaMasha

📇 Хотите свою книгу? Мы напишем её за вас и сделаем книгу бестселлером. Подробности в боте @Summary_library_bot

🏆 Оставьте след в истории с помощью книги

https://expert-book.pro

Фильмы и сериалы со всей планеты. Мы знаем, что посмотреть, где посмотреть и на что сходить в кино.

Last updated 5 days, 13 hours ago

Все материалы размещены по партнёрской програме ivi.ru | All materials are posted on the partner program ivi.ru

По всем вопросам: @kuzr103

Купить рекламу: https://telega.in/c/k1noxa103

Основной канал: https://t.me/kino_hd2

Last updated 1 month, 2 weeks ago

модели Claude 3.5 …](/media/attachments/big/bigdatai/917.jpg)

🔥 Anthropic обновила модели Claude 3.5 Sonnet и Claude 3.5 Haiku, а также представила новую функцию управления Claude компьютером!

🌟 Обновленный Claude 3.5 Sonnet демонстрирует широкомасштабные улучшения в бенчмарках, особенно в задачах агентного кодирования и использования инструментов. В кодировании он повышает производительность на SWE-bench Verified с 33,4% до 49,0%, набрав баллов больше чем все общедоступные модели, включая модели рассуждений, такие как OpenAI o1-preview и специализированные системы, разработанные для агентного кодирования

💡 Управление компьютером — это новая экспериментальная функция, позволяющая ИИ взаимодействовать с пользовательскими интерфейсами компьютера для выполнения действий в программах, как будто это делает человек. Claude способен автоматизировать рутинные операции: открывать приложения, взаимодействовать с окнами и системными функциями.

🔗 Подробнее на сайте Anthropic: клик

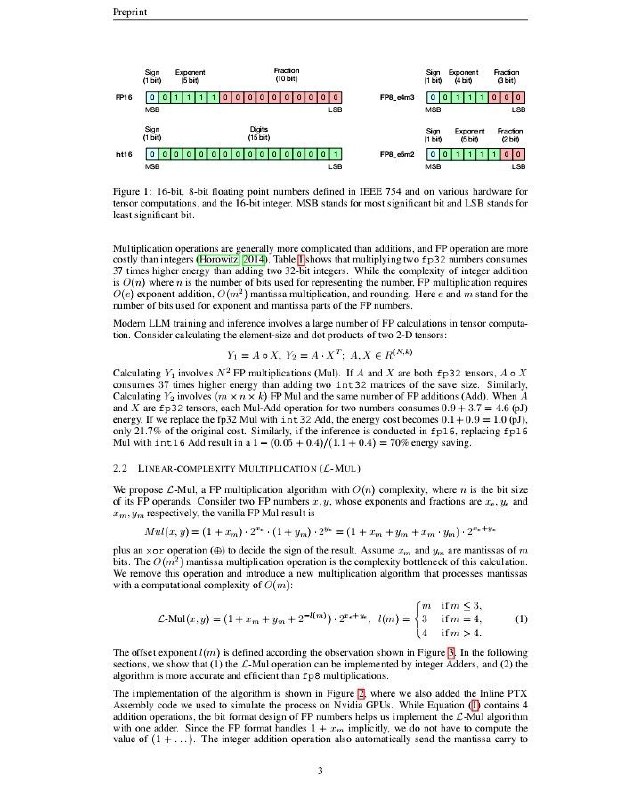

🖥 Addition is All You Need for Energy-efficient Language Models — статья, которая описывает новый метод повышения энергоэффективности языковых моделей

⭐️ Авторы предлагают использовать алгоритм L-Mul, который заменяет операции с плавающей запятой на сложения целых чисел. Это значительно снижает энергопотребление на аппаратном уровне при обработке тензоров и может повысить точность по сравнению с традиционными 8-битными операциями. Метод протестирован на различных задачах и показал минимальные потери в точности

🔗 Ссылка: клик

🌟 Zamba2-Instruct: две гибридные SLM на 2.7 и 1.2 млрд. параметров.

Zamba2-Instruct - семейство инструктивных моделей на архитектуре Mamba2+Transformers для NLP-задач.

В семействе 2 модели:

🟢Zamba2-1.2B-instruct;

🟠Zamba2-2.7B-instruct.

Высокая производительность семейства по сравнению с релевантными Transformers-only моделями достигается за счет конкатенации эмбедингов модели с входными данными для блока внимания и использование LoRA projection matrices к общему MLP-слою.

Модели файнтюнились (SFT+DPO) на instruct-ориентированных наборах данных (ultrachat_200k, Infinity-Instruct, ultrafeedback_binarized, orca_dpo_pairs и OpenHermesPreferences).

Тесты Zamba2-Instruct продемонстрировали внушительную скорость генерации текста и эффективное использование памяти, обходя MT-bench более крупные по количеству параметров модели/ (Zamba2-Instruct-2.7B превзошла Mistral-7B-Instruct-v0.1, а Zamba2-Instruct-1.2B - Gemma2-2B-Instruct)

⚠️ Для запуска на СPU укажите use_mamba_kernels=False при загрузке модели с помощью AutoModelForCausalLM.from_pretrained.

▶️Локальная установка и инференс Zamba2-2.7B-Instruct:

```

# Clone repo

git clone https://github.com/Zyphra/transformers_zamba2.git

cd transformers_zamba2

# Install the repository & accelerate:

pip install -e .

pip install accelerate

# Inference:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

tokenizer = AutoTokenizer.from_pretrained("Zyphra/Zamba2-2.7B-instruct")

model = AutoModelForCausalLM.from_pretrained("Zyphra/Zamba2-2.7B-instruct", device_map="cuda", torch_dtype=torch.bfloat16)

user_turn_1 = "user_prompt1."

assistant_turn_1 = "assistant_prompt."

user_turn_2 = "user_prompt2."

sample = [{'role': 'user', 'content': user_turn_1}, {'role': 'assistant', 'content': assistant_turn_1}, {'role': 'user', 'content': user_turn_2}]

chat_sample = tokenizer.apply_chat_template(sample, tokenize=False)

input_ids = tokenizer(chat_sample, return_tensors='pt', add_special_tokens=False).to("cuda")

outputs = model.generate(**input_ids, max_new_tokens=150, return_dict_in_generate=False, output_scores=False, use_cache=True, num_beams=1, do_sample=False)

print((tokenizer.decode(outputs[0])))

```

📌Лицензирование : Apache 2.0 License.

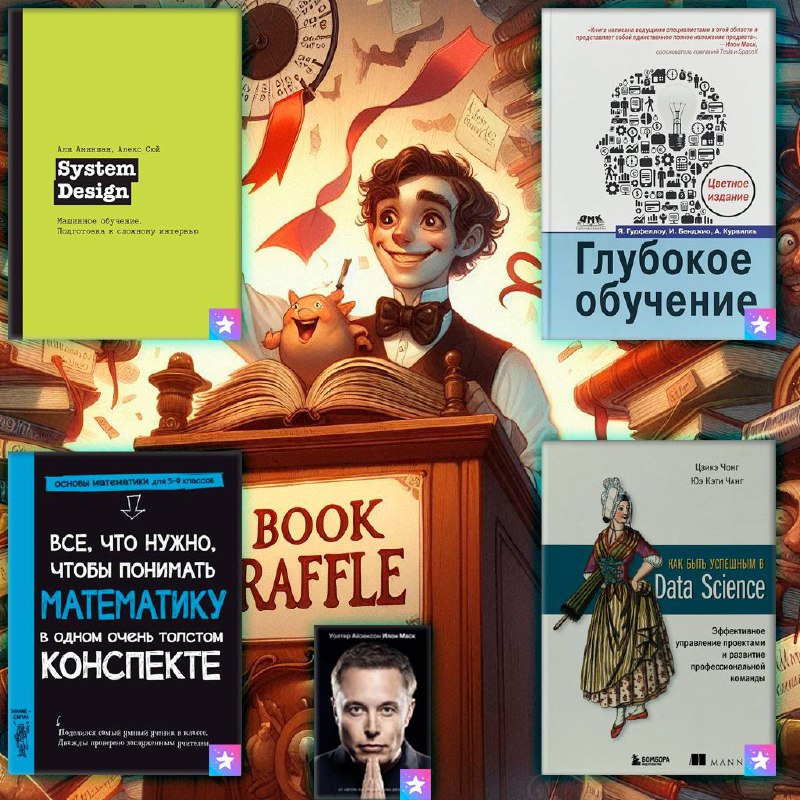

*📚 *Пришло время провести розыгрыш подарков для буста вашей карьеры

На этот раз мы разыграем целую коллекцию актуальных и нужных книг Дата Саентиста.

Условия просты:

👉 подписаться на Machine Learning,

👉 подписаться на Нескучный Data Science

Каждый победитель получит Telegram Premium и одну из книг, которые рекомендуют прочитать авторы каналов:

📖 System Design. Машинное обучение. Подготовка к сложному интервью | Сюй Алекс

📖 Глубокое обучение Курвилль Аарон, Гудфеллоу Ян📖 Как быть успешным в Data Science.

📖 Все, что нужно, чтобы понимать математику в одном толстом конспекте

📖 Илон Маск | Айзексон Уолтер

Итоги подведем при помощи бота, который рандомно выберет победителя. Всем удачи ❤️

P.S. Не забывайте ставить огонек под этим постом. Поговаривают, что шанс на победу может увеличится ))) 🔥

Большая шпаргалка по SQL — внутри ждёт всё, от основных команд до продвинутых фишек, вроде оконных функций.

— Основные команды SQL;

— SOL Joins;

— SQL Unions, Intersect, Except;

— Временные таблицы SQL, таблицы просмотра, CTE;

— Ранги SQL.

Сохраняйте себе, чтобы не потерять.

✔️ "Электронный язык" с ИИ распознает вкусовые характеристики.

Ученые из Penn State разработали электронный язык, способный различать жидкости - молоко с разным содержанием воды, различные виды соды и кофе, а также определять свежесть соков и потенциальные проблемы с безопасностью пищевых продуктов.

Язык использует графеновый ионно-чувствительный транзистор, подключенный к нейронной сети. ИИ сначала оценивал жидкости по 20 заданным параметрам, достигнув точности более 80%. Однако, когда ИИ самостоятельно определял параметры оценки, точность возросла до 95%.

Исследователи использовали метод Shapley Additive Explanations, чтобы понять, как ИИ принимает решения, и обнаружили, что он учитывает более тонкие характеристики данных. По словам исследователей, возможности языка ограничены только данными, на которых он был обучен.

psu.edu

*✔️ *Google представляет Tx-LLM: Модель ИИ для ускорения разработки лекарств.

Google представила новую большую языковую модель Tx-LLM, разработанную для прогнозирования свойств биологических объектов на всех этапах разработки лекарств. Tx-LLM обучена на 66 наборах данных, охватывающих задачи от ранней идентификации целевых генов до утверждения клинических испытаний на поздних стадиях.

Модель Tx-LLM, построенная на базе PaLM-2, достигла конкурентоспособных результатов по сравнению с современными моделями, превзойдя их в 22 из 66 задач. Tx-LLM продемонстрировала способность эффективно объединять молекулярную информацию с текстовой и переносить знания между задачами с различными типами терапии.

Google планирует предоставить доступ к Tx-LLM внешним исследователям для ускорения процесса разработки лекарств.

research.google

✔️ Tesla готовится к презентации роботакси.

Tesla проводит мероприятие под названием «Мы, роботы», 10 октября в 19.00 EPT (2:00 11 октября GMT) на котором, как ожидается, будет представлен дизайн роботакси - автомобиля Tesla, предназначенного исключительно для перевозки пассажиров без водителя.

На мероприятии также может быть представлен гуманоидный робот Optimus.

npr.org

✔️ Liftoff запускает Cortex, модель машинного обучения для улучшения мобильной рекламы.

Liftoff, занимающаяся консалтингом мобильных приложений, запустила новую платформу машинного обучения под названием Cortex. Эта платформа использует специализированные модели нейронных сетей для повышения эффективности мобильных рекламных кампаний.

Cortex позволяет достичь более высокой рентабельности инвестиций в рекламу, определяя наилучшие каналы и аудитории для рекламных кампаний. По данным Liftoff, Cortex уже показал положительные результаты: снижение стоимости установки (CPI) на 23%, стоимости привлечения клиента (CPA) на 21% и увеличение рентабельности рекламных расходов (ROAS) на 16%.

venturebeat.com

✔️ Выпущен релиз Gradio 5.

Gradio выпустила стабильную версию Gradio 5, он получил ряд улучшений, направленных на решение проблем, с которыми сталкивались разработчики ранее.

Среди ключевых обновлений: улучшенная производительность за счет рендеринга на стороне сервера (SSR), обновленный дизайн основных компонентов и новые темы, поддержка потоковой передачи с низкой задержкой, включая WebRTC, экспериментальная AI-площадка для генерации и модификации приложений с помощью ИИ.

В ближайшее время планируется добавить поддержку многостраничных приложений, мобильных устройств и новые компоненты для работы с изображениями и видео.

huggingface.co

✔️ NVIDIA поставила долгожданные чипы Blackwell AI в OpenAI и Microsoft.

OpenAI объявила, что получила первые инженерные образцы DGX B200 от Nvidia. Они обещают трехкратное увеличение скорости обучения и 15-кратное увеличение производительности инференса по сравнению с предыдущими моделями.

Microsoft также сообщила, что ее платформа Azure первой использует систему Blackwell от Nvidia с AI-серверами на базе GB200.

analyticsindiamag.com

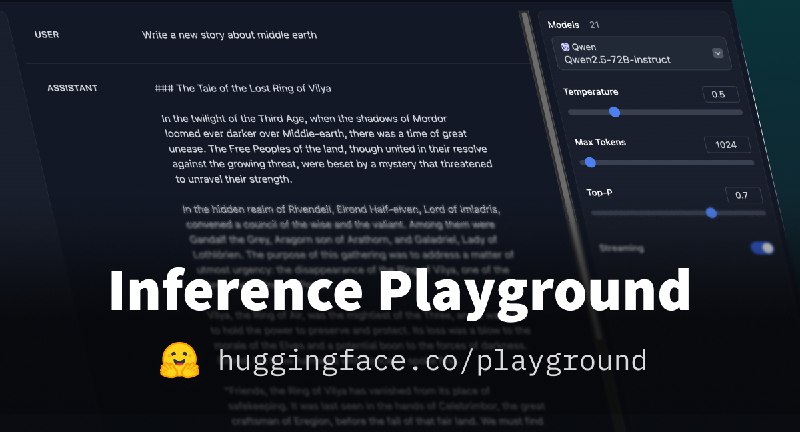

Qwen2.5-72B теперь доступен для пользователей бесплатного уровня на HF Serverless Inference API (с щедрой квотой)!

Начать работу можно здесь: https://huggingface.co/playground?modelId=Qwen/Qwen2.5-72B-Instruct

— созданная OpenAI универсальная …](/media/attachments/big/bigdatai/881.jpg)

🖥 Whisper — созданная OpenAI универсальная модель распознавания речи, обученная на большом объеме данных. Она способна выполнять мультиязычное распознавание речи, перевод речи и идентификацию языка. Whisper поддерживает несколько размеров моделей, оптимизированных для различных сценариев (разных размеров, с разной точностью и производительностью)

🌟 Модель можно использовать через командную строку или в Python

🔐 Лицензия: MIT

📊 Обработка больших данных с использованием Apache Flink

Apache Flink предлагает расширенные возможности для потоковой и пакетной обработки данных.

💼 Эта мощная платформа призвана помочь вам поработать с миллионами записей в реальном времени.

Поддерживает сложные события и состояние в реальном времени.

🔗 Ознакомьтесь с ресурсами: Apache Flink Documentation

💡 Откройте для себя новые горизонты обработки данных!

Бизнес блог #1

Выжимаю книги до самой сути.

👉 Реклама - @jaMasha

📇 Хотите свою книгу? Мы напишем её за вас и сделаем книгу бестселлером. Подробности в боте @Summary_library_bot

🏆 Оставьте след в истории с помощью книги

https://expert-book.pro

Фильмы и сериалы со всей планеты. Мы знаем, что посмотреть, где посмотреть и на что сходить в кино.

Last updated 5 days, 13 hours ago

Все материалы размещены по партнёрской програме ivi.ru | All materials are posted on the partner program ivi.ru

По всем вопросам: @kuzr103

Купить рекламу: https://telega.in/c/k1noxa103

Основной канал: https://t.me/kino_hd2

Last updated 1 month, 2 weeks ago