Awesome DL

Автор: @anvilarth

Boost: https://t.me/awesome_dl?boost

Architec.Ton is a ecosystem on the TON chain with non-custodial wallet, swap, apps catalog and launchpad.

Main app: @architec_ton_bot

Our Chat: @architec_ton

EU Channel: @architecton_eu

Twitter: x.com/architec_ton

Support: @architecton_support

Last updated 2 weeks, 2 days ago

Канал для поиска исполнителей для разных задач и организации мини конкурсов

Last updated 1 month ago

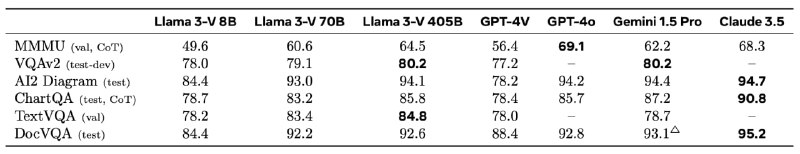

Мой друг Саид замутил модельку мирового уровня, поэтому считаю важным поделиться с вами 😎

?Всем привет!

Сегодня наконец-то закончил статью про аугментации (об этом расскажу позже, но название точно топ ?, легко продаётся :) ). В ближайшее время вернусь к написанию постов. А чтобы заполнить паузу хочу поделиться с вами крутым видео про детекцию мелких объектов.

? Мну уже надоели сложности детекции во время написания статьи, и чтобы разобраться, важен прикладной опыт и реальные кейсы.

А из видео я впервые узнал о методе SAHI (Slicing Aided Hyper Inference). Этот метод помогает лучше находить мелкие объекты на изображениях, засчёт sliced inference, когда моделька проходится по картинке небольшим окошком и детектирует все объекты в нём. В видео ещё много полезного про обучение, аугментации и выбор моделей — всё это точно пригодится, если вы занимаетесь компьютерным зрением и поможет забустить метрики, что мне бы сейчас точно не помешало, потому что метрики выбивать целое искусство!

?Очень советую посмотреть! А я пошел восстановливаться ?

Всем привет! Выкладываю вчерашную презентацию по теме "Генеративные аугментации в задачах компьютерного зрения"

⚡️Сегодня мы выложили наш фреймворк для обработки и фильтрации изображений и видео

DPF - это наш внутренний фреймворк, с помощью которого мы обрабатывали и чистили датасет для обучения моделей Kandinsky и Kandinsky Video. Репозиторий содержит фильтры для видео, изображений, различных комбинаций этих модальностей, а также удобный интерфейс к ним. Надеемся, что открытие кода ускорит развитие библиотеки и даст возможность ресерчам сосредоточиться на ресерче, а не на чистке данных ❤️?

А ещё мы написали статью на habr, в которой подробно рассказали про то, как собирали датасет для обучения Kandinsky 3.0 & 3.1 и Kandinsky Video. В ней также рассказали про DPF и процесс обработки датасетов у нас в Sber AI.

Вот один из секретов успеха

Сап чат!

Data Fest 2024 уже совсем скоро, и сегодня у нас ударный пост с эпичным вскрытием карт и открытием регистраций ?

В этом году мы чутка нарастили и программу и географию и число локаций ?

12 оффлайн площадок уже открыты — можно регистрироваться ?

24 мая (пт): Москва, Pre-Party Феста с Яндексом

25 мая (сб): Москва, самый крупный офлайн день Феста в гостях у VK

26 мая (вс): Ереван, офлайн митап в гостях у РАУ

29 мая (ср): Москва и Питер — день Феста в гостях у ВТБ в Москве плюс день Феста в гостях у Альфа-Банка х ИТМО в Питере

31 мая (пт): Алматы и Москва — вечерний офлайн митап в гостях у Altel digital в Алматы и день Феста в гостях у Цифровой кафедры Альфа-Банка в Финансовом Университете в Москве

01 июня (сб): Алматы, Новосибирск и Москва — день Феста в гостях у Citix в Алматы, три зала и целый день Феста в гостях у МехМата НГУ в Новосибирске и целый день Феста в гостях у Avito.tech в Москве

02 июня (вс): Москва и Питер — завершаем программу с финальным днем Феста в гостях у Яндекса в Москве и днем Феста в гостях у VK в Питере!

На каждой площадке будет свой состав секций и спикеров — каждый найдёт себе ивенты под свои интересы ?

Плюс планируется огромное количество online активностей в Spatial.Chat, программу в котором будем анонсировать по мере готовности ?️️️️ А что-то можно уже сейчас найти на странице Феста

Ждём на Фесте, где бы в пространстве-времени он не оказался! ?️️️️️️

Diffusion Models GuideBook

У меня появилось желание собрать всё знания, которые помогут разобраться с диффузионными моделями и найти себя в них. Поэтому, вот и пост ?

*❗️*База, чтобы понять что к чему

- https://lilianweng.github.io/posts/2021-07-11-diffusion-models/ — скинуть, кому-то чтобы понять, что такое диффузии. Не слишком много подробностей, но уловить суть позволяет.

- https://archive.is/gpfgl — более глубокое погружение на 60 минут, с очень подробным выводом диффузии и куча пояснений, откуда берётся каждая компонента, если вы прям хотите разобраться в нюансах.

- https://www.youtube.com/watch?v=1d4r19GEVos — подробный обзор диффузии и её разнообразных применений в различных с CVPR — поможет понять, где можно применять диффузии.

- https://www.youtube.com/watch?v=DsEDMjdxOv4 — текущее состояние диффузионных моделей с разным анализом.

*? Для любителей прям в глубины и готовых изучить теорию генеративных моделей*

- https://www.youtube.com/watch?v=yUnIzzNiyho&list=PL2UML_KCiC0UPzjW9BjO-

IW6dqliu9O4B&index=13

- https://deepgenerativemodels.github.io/syllabus.html — два курса по генеративным моделям, которые стоит посмотреть, чтобы понять, а откуда берутся генеративные модели и что с ними можно делать. В часте курса есть лекции про диффузии, их тоже рекомендую посмотреть.

- https://github.com/r-isachenko/2023-DGM-MIPT-course — на русском языке лучший курс по генеративным моделям от преподавателя AI Masters/MIPT Романа Исаченко. Сам проходил ?

*? Зачем вы полезли в диффузии или я хочу разобраться в них серьёзно*

- https://github.com/diff-usion/Awesome-Diffusion-Models — чтобы во всем самому разобраться, потому что вы "Big boy". Отличный набор постов и туториалов, из которых вы можете выбрать подходящий

- https://github.com/wangkai930418/awesome-diffusion-categorized — актуальная штука по диффузиям, увидев столько секций и статей я словил FOMO, потому что реально много статей, которые очень хорошо покрывают все темы

- https://github.com/YangLing0818/Diffusion-Models-Papers-Survey-Taxonomy — если вы гик, которому важно понимать каждую деталь и структуру в диффузиям, то это вам прочитать. *? Если вам это мало и хотите самый новых и потенциально более крутых вещей*

Различные обобщения диффузионных, которые постепенно начинают приходить в нашу ML жизнь:

- Flow matching — обобщение диффузионных моделей, которое позволяет отображать из любого распределения в любое. (Диффузии отображают только из нормального в реальное)

- Stochastic Interpolants — объединение flow-based и diffusion-based моделей

- Bridge matching — стохастическое обобщение задачи Optimal Transport

❗️Сохраняйте к себе и пересылайте друзьям, чтобы быть в этой теме. Пишите в комментариях ваши замечания и идеи, чем можно дополнить обзор

P.S. Особая благодарность @Magistrkoljan за помощь с самыми современными методами диффузий

lilianweng.github.io

What are Diffusion Models?

[Updated on 2021-09-19: Highly recommend this blog post on score-based generative modeling by Yang Song (author of several key papers in the references)]. [Updated on 2022-08-27: Added classifier-free guidance, GLIDE, unCLIP and Imagen. [Updated on 2022-08…

Architec.Ton is a ecosystem on the TON chain with non-custodial wallet, swap, apps catalog and launchpad.

Main app: @architec_ton_bot

Our Chat: @architec_ton

EU Channel: @architecton_eu

Twitter: x.com/architec_ton

Support: @architecton_support

Last updated 2 weeks, 2 days ago

Канал для поиска исполнителей для разных задач и организации мини конкурсов

Last updated 1 month ago