SEO hive

А также, про SEO-кейсы и аналитику, которые меня заинтересовали)

Автор: @AlexanderRahmanin

Architec.Ton is a ecosystem on the TON chain with non-custodial wallet, swap, apps catalog and launchpad.

Main app: @architec_ton_bot

Our Chat: @architec_ton

EU Channel: @architecton_eu

Twitter: x.com/architec_ton

Support: @architecton_support

Last updated 2 weeks, 6 days ago

Канал для поиска исполнителей для разных задач и организации мини конкурсов

Last updated 1 month, 1 week ago

*🔍*🧐Поиск в chatGPT**

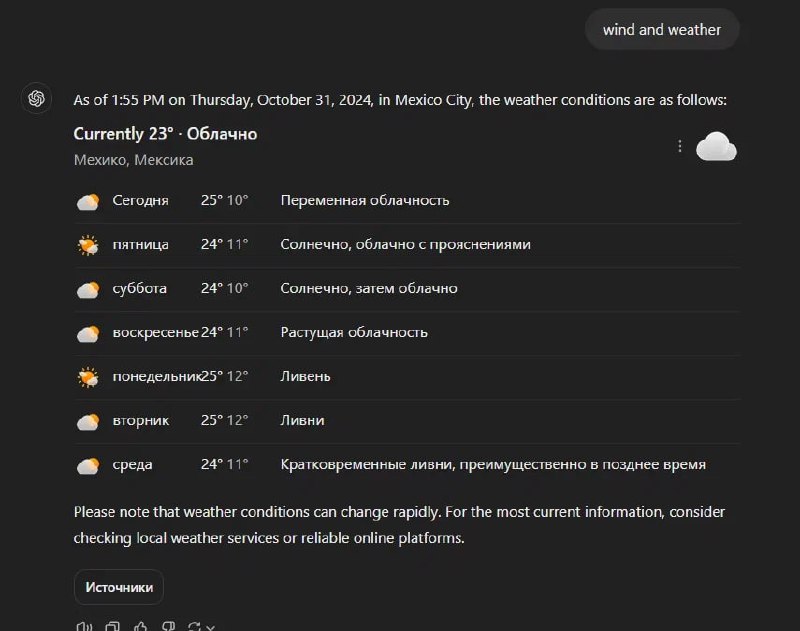

Open AI запустили полноценный поиск в chatGPT. Многие уже пользовались chatGPT для поиска ответов на вопросы. Но теперь можно получить ответ на некоторые коммерческие запросы:

1️⃣Поиск ресторана. ChatGPT даже пытается дать ответ как можно ближе к пользователю. Пока так себе, но с конкретным топонимом работает лучше.

2️⃣Поиск отеля. Тут также работает ГЕО привязка пользователя.

3️⃣Поиск товаров и услуг. Тут пока нельзя что-то купить, но ответ выглядит один в один, как таблица на сайте под амазон 😁

❔Также добавили специальные ответы на информационные запоры, но где нужна самая актуальна я информация: погода, акции и новости.

🤔На данный момент я не вижу большого смысла в подобных ответах. Такой же запрос проще сделать в Google, где все давно настроено и есть собственные сервисы. Разве что это может пригодиться при поиске какого-то уникального отеля или ресторана. У ChatGPT много преимуществ перед Google и другими поисковыми системами, и, на мой взгляд, стоит развивать именно сильные стороны, а не пытаться конкурировать с поисковиками на их территории.

❗️Но мини хайп все же есть! Уже сейчас можно посмотреть, как будут выглядеть ИИ ответы Яндекс и Google в следующем году 😊

*🚀ChatGPT-4 бесплатно и без регистрации ☺️*

Бесплатные провайдеры chatGPT переходят на GPT-4o. Сhat18.aichatos8.com отвечает, что основан на GPT-4 и данные актуальные на 27 августа 2024 года. При этом на сайте написано, что бесплатно доступна только GPT-3.5. Скорее всего специально, чтобы у них покупали платную подписку с GPT-4 😊

Все дело в том, что GPT-4o благодаря оптимизации стоит дешевле GPT-3.5. API gpt-3.5 turbo стоит $0,5 за 1м токенов, а gpt-4o mini $0,15 😱

Также скрипт для Google таблицы все еще работает. И теперь в таблицах можно бесплатно подключить GPT-4o 👍

?Создание PBN с помощью chatGPT

?Хоть PBN и расшифровывается как Private Blog Network, я часто разворачиваю небольшие статичные сайты-калькуляторы, чтобы с них ставить ссылки ?

?Сейчас благодаря скорости chatGPT 4o, можно верстать небольшие сайты с рабочим функционалом и на нескольких языках.

?Делюсь с вами примером генерации калькулятора для фотометрии.

?Ссылка на промт.

Промт выглядит сложным, но он довольно шаблонный, а что-то можно просто сгенерить. Например, ТЗ по дизайну и цветам я попросил написать chatGPT.

1️⃣Сначала chatGPT выдаст структуру сайта. По этой структуре нейронка сделает ссылки и подключит стили и скрипты в верстке. Эту структуру вам нужно будет повторить на сервере, разложив файлы по папкам.

2️⃣Далее GPT генерирует css, js и английскую верстку. Я специально разделил промт на несколько запросов, чтобы chatGPT успевал его выполнять ?♂️

3️⃣Потом просто по очереди генерим остальные языки

4️⃣Остается только создать файлы на сервере и скопировать в них полученный код.

?В результате получился вот такой сайт ?

Он простой и статичный, но зато с работающим функционалом, несколькими языковыми версиями и техническими станицами всего за 15 минут ?

?Если вам интересно, ставьте лайки и я расскажу подробнее про такие PBN ?

Слив внутренней инженерной документации Google Search API - часть 3

По сливу читайте предыдущие посты по хештегу #слив ?

Еще факты:

1. Эта утечка не вырвана из контекста, не устарела и не является неполной информацией.

-

Navboost, основанный на данных о кликах, чрезвычайно важный фактор ранжирования в поиске, и теперь благодаря этой утечке мы знаем, что это исходит от Chrome.

-

Существуют токсичные обратные ссылки, с документами связана функция badbacklinksPenalized.

-

Есть штрафной вызов за плохие обратные ссылки.

-

Google может ограничивать количество сайтов определенного типа, появляющихся в результатах.

-

Слова или фразы, которые ассоциируются с объектом могут повлиять на рейтинг в поисковых системах так же, как это делают ссылки (сразу вспоминается кейс от Михаила Шакина, где он говорил, что гостевой пост с брендом, но без ссылки показал хороший результат).

-

Существует оценка соответствия заголовка для сайта, а не только для отдельных страниц.

-

Соответствие заголовка страницы — важный фактор.

-

Google может указать ограничение результатов для каждого типа контента. Другими словами, они могут указать только количество X сообщений в блогах или количество Y новостных статей, которые могут появиться для данной поисковой выдачи.

-

Модуль QualityTravelGoodSitesData имеет функции, которые идентифицируют и оценивают туристические сайты, предположительно, чтобы дать им преимущество перед неофициальными сайтами.

-

Google определяет, какой контент можно или нельзя использовать из Knowledge Graph с LLM.

-

Возможно, Google с помощью LLM для прогнозирования тему видео.

-

Google пытается определить количество усилий, затрачиваемых при создании контента. Основываясь на определении, мы не знаем, оценивается ли LLM таким образом весь контент или это просто контент, который, как они подозревают, создан с использованием генеративного ИИ.

-

Значимость обновления страницы влияет на то, как часто страница сканируется и потенциально индексируется. Раньше вы могли просто изменить даты на своей странице, и это сигнализировало Google о ее свежести, но Google ожидает более значительных обновлений на странице.

-

В модуле блога BlogPerDocData есть подражатель без определения, но привязанный к docQualityScore, скорее всего, это мера дублирования сообщений в блогах.

-

Механизм выборки робота Googlebot способен выполнять не только запросы GET. В документации указано, что он также может выполнять запросы POST, PUT или PATCH.

-

Google определяет, насколько коммерческая страница.

-

Успехом также считается поиск, при котором происходит клик и пользователь проводит на странице 5 минут, прежде чем вернуться в Google.

-

Ценность ссылок выше на страницах, которые имеют более высокий приоритет в индексе.

-

Twiddlers — это алгоритмы переоценки, которые работают между крупными обновлениями и сменой рейтинга в поисковой выдаче.

-

Чрезмерно оптимизированный якорный текст, особенно если он постоянно используется для ссылок на ваш сайт со стороны третьих лиц, похоже, вызывает спам-понижение этих ссылок.

-

Плохая навигация и домены с точным соответствием могут снизить ваш рейтинг.

-

У Google есть показатель наполнения ключевыми словами.

-

Google отслеживает срок действия доменов, поэтому они либо уже могут, либо скоро смогут обнаружить злоупотребления в отношении просроченных доменов.

-

Нет четкого упоминания внутренних ссылок как атрибута.

Источники:

1. https://sparktoro.com/blog/11-min-video-the-google-api-leak-should-change-how-marketers-and-publishers-do-seo/

Про сам слив можно подробнее тут почитать

Слив внутренней инженерной документации Google Search API - часть 2

Алгоритмы из слива:

1. Trawler – система сканирования веб-страниц. Он имеет очередь сканирования , поддерживает скорость сканирования и понимает, как часто меняются страницы.

-

Alexandria – основная система индексации.

-

SegIndexer – система, которая помещает документы уровней в уровни индекса.

-

TeraGoogle – вторичная система индексирования документов, которые долго хранятся на диске.

-

HtmlrenderWebkitHeadless – система рендеринга страниц JavaScript.

-

LinkExtractor – извлекает ссылки со страниц.

-

WebMirror – система управления канонизацией и дублированием.

-

Mustang – основная система подсчета очков, ранжирования и обслуживания.

-

Ascorer – основной алгоритм ранжирования, который ранжирует страницы перед любыми корректировками повторного ранжирования.

-

NavBoost – система повторного ранжирования на основе журналов кликов о поведении пользователей.

-

FreshnessTwiddler – система изменения рейтинга документов на основе свежести.

-

WebChooserScorer – определяет имена функций, используемые при оценке фрагментов.

-

Google Web Server (GWS) — это сервер, с которым взаимодействует интерфейс Google. Он получает полезные данные для отображения пользователю.

-

SuperRoot – это мозг Google Search, который отправляет сообщения на серверы Google и управляет системой постобработки для повторного ранжирования и представления результатов.

-

SnippetBrain – система, которая генерирует фрагменты результатов.

-

Glue – система объединения универсальных результатов на основе поведения пользователя.

-

Cookbook – Система генерации сигналов. Есть указание на то, что значения создаются во время выполнения.

-

SiteFocusScore – фиксирует, насколько сайт придерживается одной темы.

Слив внутренней инженерной документации Google Search API - часть 1

Факты из слива:

1. Navboost и использование кликов, CTR, длинные и короткие клики и пользовательские данные.

-

Использование статистики кликов браузера Chrome для улучшения поиска в Google.

-

Белые списки сайтов в сфере путешествий, Covid и политики.

-

Использование отзывов оценщиков качества.

-

Использование данных о кликах, чтобы определить вес ссылок в рейтинге.

-

У Google есть функция, которую они вычисляют, под названием «siteAuthority» для оценки сигналов качества, которые хранятся отдельно для каждого документа.

-

Оказывается, песочница все-таки есть в Google.

-

Google сохраняет авторов, связанных с документом, система также пытается определить, является ли объект на странице ее автором.

-

Уровень индексирования влияет на ценность ссылки.

-

Google использует только последние 20 изменений для данного URL-адреса при анализе ссылок.

-

PageRank домашней страницы учитывается для всех страниц.

-

Размер шрифта терминов и ссылок имеет значение.

-

Данные об отклонении ссылок не связаны с основными системами ранжирования.

-

Короткий контент оценивается за его оригинальность. Вероятно, поэтому тонкий контент не всегда зависит от длины.

-

Title по-прежнему оценивается по запросам.

-

Длинные Title неоптимальны для увеличения количества кликов, но они хороши для повышения рейтинга.

-

Даты документа очень важны (дата публикации, дата изменения).

-

Если более 50% страниц сайта содержат видео, сайт считается ориентированным на видео, и к нему будут относиться по-другому.

-

Существуют документы золотого стандарта.

-

Your Money Your Life имеет специальную оценку.

-

Google специально векторизует страницы и сайты и сравнивает встраивания страниц с встраиваниями сайтов, чтобы увидеть, насколько страница не по теме.

-

У Google есть специальный флаг, который указывает, что сайт является «небольшим персональным сайтом».

-

SiteFocusScore – фиксирует, насколько сайт придерживается одной темы.

*❌Как удалить конкурента из поисковой выдачи Яндекс

‼️Данный способы сработают у вас только если конкурент нарушил правила и украл у вас контент или незаконно использует ваш бренд. Поэтому сразу говорю, что название кликбейт ?*

❓Но думаю, что многим все равно будет полезно. Потому что часто обращения к доменному регистратору, хостеру и всякие досудебки просто бесполезны. Я расскажу как раз про такой кейс ??

?Недобросовестный конкурент cкопировал дизайн сайта нашего клиента вместе с логотипом и брендом. Купил брендовый домен в зоне com.ru и стал ранжироваться в выдаче Яндекс вместе с нами. По некоторым брендовые запросам ранжировался выше нас ?

*?Как с ним бороться:*1️⃣ Устанавливаем антидетект браузер. Можно взять любой, но мы взяли Dolphin и дальше я буду показывать все на его примере.

2️⃣ Ещё нам понадобится один мобильный прокси. Можно купить самый дешевый тут. У мобильного прокси IP каждые пару минут, поэтому нам хватит одного прокси.

3️⃣ Создаем профиль - Скрин.

4️⃣ Делаем радомный отпечаток - Скрин.

5️⃣ Добавляем купленный прокси - Скрин.

6️⃣ Выбираем разрешение экрана. Берем 1920 × 1080, 1536 × 864 и 1536 × 864. Это популярные десктопные расширения.

7️⃣ Запускаем профиль - Скрин.

8️⃣ Заходи на ya.ru по запросам, где конкурент отбирает у вас трафик. Находим сайт конкурента. Заходим на него и возвращаемся в Яндекс. Нажимаем “сообщить об ошибке”, выбираем одну из жалоб и заполняем ее - Скрин.

9️⃣ После отправки жалобы необходимо будет оставить почту. Можно брать любую, но лучше, чтобы они были похожи на настоящие. Можно генерировать почты тут.

? После того, как оставили заявку закрываем профиль и удаляем его. В следующем профили используем другие комбинации платформы и разрешения экрана. Так же меняем слова в запросе, чтобы не заходить на сайт по одному и тому же ключу.

*?Результаты

Нам хватило всего 10 жалоб по 1-2 жалобы в день, чтобы удалить конкурента по всем нашим запросам. Вот его график видимости. Через неделю после жалоб сайт просто вылетел по нашим брендовым запросам за ТОП 50 ?*

‼️Еще раз повторю. Хороший сайт так не удалить. Способ направлен против сайтов, которые нарушают правила и нужен только, чтобы достучаться до Яндекса. Если просто писать в Яндекс от своего имени, поддержка отправит вас жаловаться хостеру и регистратору и все. А к пользователям на выдаче, как показывает этот кейс, они прислушиваются ?

?Основные ИИ инструменты для решения SEO-задач

Собрал в кучу ссылки из могу доклада на SEO CLUB SPB:

?Бесплатные провайдеры chatGPT

?ChatSEO - сервис дообученый на справке Google

?ChatAll - все нейронки в одном сервисе

Architec.Ton is a ecosystem on the TON chain with non-custodial wallet, swap, apps catalog and launchpad.

Main app: @architec_ton_bot

Our Chat: @architec_ton

EU Channel: @architecton_eu

Twitter: x.com/architec_ton

Support: @architecton_support

Last updated 2 weeks, 6 days ago

Канал для поиска исполнителей для разных задач и организации мини конкурсов

Last updated 1 month, 1 week ago