Information Retriever

Недельные дайджесты arxiv/cs.IR, обзоры статей, образовательные посты и не только

Author: @kkhrylchenko

Бизнес блог #1

Выжимаю книги до самой сути.

👉 Реклама - @jaMasha

📇 Хотите свою книгу? Мы напишем её за вас и сделаем книгу бестселлером. Подробности в боте @Summary_library_bot

🏆 Оставьте след в истории с помощью книги

https://expert-book.pro

Фильмы и сериалы со всей планеты. Мы знаем, что посмотреть, где посмотреть и на что сходить в кино.

Last updated 1 day, 8 hours ago

Все материалы размещены по партнёрской програме ivi.ru | All materials are posted on the partner program ivi.ru

По всем вопросам: @kuzr103

Купить рекламу: https://telega.in/c/k1noxa103

Основной канал: https://t.me/kino_hd2

Last updated 1 month, 2 weeks ago

В далеком 2018-м году, уже после Attention Is All You Need, но до BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding, Суцкевер на лекции в MIT пугающе точно описывал что будет происходить в ближайшие годы. В ответ на вопрос “как нам побороть проблему с генеративными LM’ками? Они плохо работают”, он уже тогда отвечал, что скорее всего достаточно замасштабироваться по данным и по модели (e.g. бахнуть тысячу одинаковых слоев), и получится гораздо лучше чем то, что было доступно на тот момент.

Но лекция была не совсем об этом, а гораздо обширней:

дал интуицию обучению нейросетей и бэкпропу в частности

сделал небольшое введение в RL

аналогично, сделал супер краткое введение в meta-learning

рассказал про self-play, верил в него как способ конвертировать compute в данные

* и даже про alignment рассказал, Deep reinforcement learning from human preferences

Это было ШЕСТЬ лет назад. Пруфы — https://youtu.be/9EN_HoEk3KY?si=T4ef2gJtDPNoZ4so

Статья на Хабре про индустриальные тренды рексистем.В мае я выступал на датафесте с докладом про тренды рексистем, а сейчас появился пост на Хабре, где мы подробнее расписали содержимое доклада, приложили ссылки на статьи, добавили больше пояснений.

Ссылка — https://habr.com/ru/companies/yandex/articles/857068/

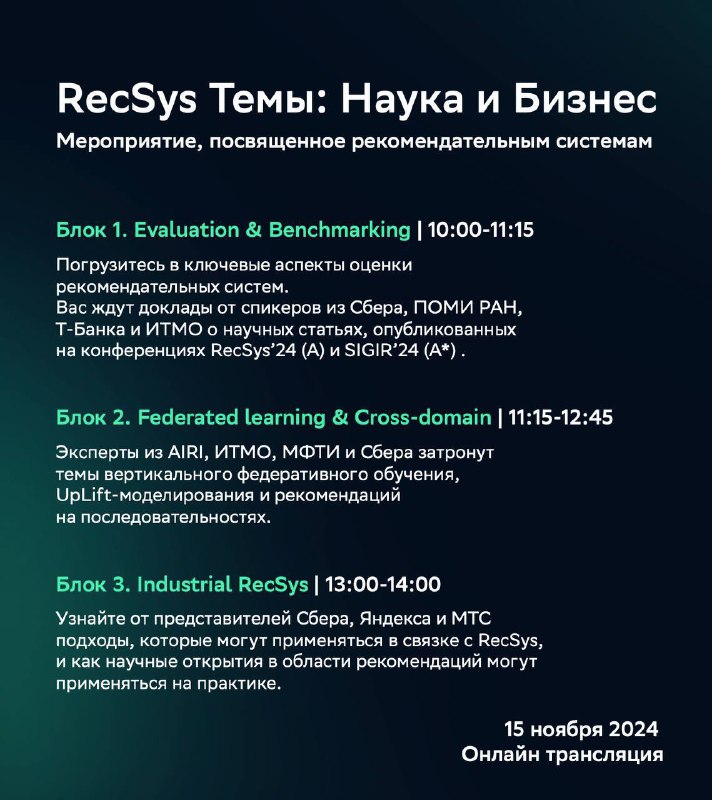

RecSys митап от Сбера.Завтра буду выступать на митапе от Сбера. Попробую за 15 минут рассказать кейсы, когда идеи из статей помогали нам на практике. Выбрал следующие пять концептов: калиброванное ранжирование, logq-коррекцию, DCN-v2, unified эмбеддинги и генеративные рексистемы.

Ссылка на трансляцию — https://jazz.sberbank.ru/sber-2p5vw5?type=webinar&role=VIEWER&psw=OAEQUkIGAx9cERdEHRIUDFMbCg.

Презентацию приложу в комментариях после выступления.

UPD: для подключения к трансляции нужно отключить проверку сертификатов, e.g. Для хрома — open -a "Google Chrome" --args --ignore-certificate-errors; или установить некий sberjazz

Related Pins at Pinterest: The Evolution of a Real-World Recommender System.

В далеком 2013-м году два инженера из Пинтереста за три недели склепали первую версию рексистемы для рекомендаций похожих пинов: взяли Pin-Board граф, посчитали мапредьюсом совстречаемости пинов, положили результаты в kv-хранилище. Через два года под развитие этого модуля выделили отдельную команду, и к моменту, когда в 2017-м году была опубликована обсуждаемая статья, уже 40% всех показанных и сохраненных пинов атрибуцировалось рекомендациям похожих пинов.

Что было сделано:

-

Перешли на случайные блуждания (Pixie) вместо мапредьюсного подсчета совстречаемостей. Вдохновлялись наработкой Твиттера аж 2013-го года, WTF: The Who to Follow Service at Twitter. Как минимум забустили качество для более редких, "тяжелохвостовых" пинов, у которых не набиралось достаточное количество соседей в своих бордах.

-

Добавили ранжирование:

- вырастили клики и сохранения пинов на 30% с помощью линейной модели над девятью фичами, использующей только характеристики query/candidate пинов (эмбеды текстов, картинки, категории, etc)

- добавили персонализацию: историю пользователя, соцдем, etc

- перешли на градиентный бустинг: это позволило упростить препроцессинг фичей (нормализацию, бакетизацию, etc), а также дало возможность добавлять query-level фичи

- пересели на pointwise (!) лосс вместо pairwise

-

spoiler: позже они перейдут на ранжирующую нейросеть, о чем я рассказывал в посте про эволюцию ранжирования в Pinterest

-

Увеличили полноту/разнообразие кандидатогенерации, добавив больше источников кандидатов:

- Pin2Vec: word2vec над сессиями пользователей, эмбеды пинов из которого используются в ANNS

- поисковые кандидаты: ходят с текстовыми аннотациями query-пина в свой текстовый поиск, и с картинкой в визуальный; помогло с холодным стартом

-

"срезовые" кандидатогенераторы: выделили отдельные кандидатогенераторы для более специфичных срезов пинов (e.g. свежие, региональные пины)

-

Про проблемы:

- фидбек луп: не получалось побить продовую ранжирующую модель, обучаясь на её же фидбеке; выделили для обучения 1% трафика, в котором отобранные кандидаты ранжировались случайно. Получили более хорошие модели, чем на исходном большом трафике

- меморизующие счетчики: была еще такая штука как MemBoost, которая изначально использовалась как прибавка к скору Pin-Board совстречаемости; по сути, это взвешенная сумма счетчиков вида "сколько раз при показе данного кандидата по этому запросу пользователи его сохраняли/кликали/etc". После введения ранжирующей модели стали использовать их в качестве фичей. Заметили, что из-за них сложно проводить АБ — эффекты от оцениваемых изменений прорастают через них в другие сплиты, и обратный эксп тоже нормально не поставишь; но ничего с этим не сделали

-

столкнулись с тем, что любое изменение в рексистеме инвалидирует оптимальность всех ее компонентов, и всякие захардкоженные гиперпараметры/константы нужно переподбирать; полечили это автоматизацией — при каждом изменении стараются как можно больше всего автоматически перетюнить

-

Еще чуть про инфру:

- было сложно итерироваться, когда весь стек, включая ранжирование, был оффлайновый; каждое изменение ранжирования/кандгена требовало полный переобход всей базы; покрытие запросов тоже было не очень; в итоге перевели ранжирование и большую часть кандидатогенераторов в онлайн

- передавать по сети туда-сюда сырые данные пинов, чтобы посчитать фичи — затратно, система будет упираться в сеть; поэтому делают шардирование исходной базы кандидатов; на каждом шарде хранятся все сырые данные про пины и сразу считаются все нужные скоры / фичи

Это была краткая историческая сводка из 2017-го года. Что произошло за следующие семь лет? To be continued :)

#arxiv_weekly (05.08.24 — 09.08.24)

Сводка новостей с arxiv recent ir.

-

Товарный поиск: Амазон исследует пользу от query understanding модуля в ранжировании (статья Exploring Query Understanding for Amazon Product Search), а в JD.com улучшают качество классификации интентов на тяжелом хвосте запросов с помощью графовых нейросетек A Semi-supervised Multi-channel Graph Convolutional Network for Query Classification in E-commerce.

-

LLM: в Гугле продолжают покорять рекомендашки языковыми моделями в статьях Leveraging LLM Reasoning Enhances Personalized Recommender Systems от команды Ed Chi (на амазоновских beauty и movies/tv), и PERSOMA: PERsonalized SOft ProMpt Adapter Architecture for Personalized Language Prompting от других товарищей из Google Research (на movielens). У Linkedin вышла статья про LLM и графы, Understanding and Modeling Job Marketplace with Pretrained Language Models.

-

Uncertainty modeling: любопытная статья от Shopee Discovery Ads про моделирование uncertainty для генерации кандидатов. При моделировании тяжелого хвоста айтемов имеем большую неопределенность, влияющую на построение индекса и поиск по нему. Утверждается, что при построении индекса хотим свести неопределенность к минимуму (для высокой релевантности), а при поиске в индексе хотим побольше неопределенности (для новизны). В том числе предлагают как эту uncertainty моделировать в нейросетях. Статья Deep Uncertainty-Based Explore for Index Construction and Retrieval in Recommendation System.

Еще одна статья на тему uncertainty от Alibaba Group: Modeling User Intent Beyond Trigger: Incorporating Uncertainty for Trigger-Induced Recommendation. Чуть статы: при клике на товар-клавиатуру, 46.9% в последствии купят какую-нибудь клавиатуру, 30.8% купят что-нибудь популярное, и 22.3% купят что-то комплементарное (e,g. мышку). В самой статье опять предлагают какие-то "модули": "we design an Explicit Intent Exploit Module (EIEM), Latent Intent Explore Module (LIEM), Intent Uncertainty Measurement Module (IUMM)", вчитываться я не стал :)

-

В тему последнего поста от Миши про генерацию кандидатов на GPU, в Xiaohongshu Inc опубликовали статью с говорящим названием A Real-Time Adaptive Multi-Stream GPU System for Online Approximate Nearest Neighborhood Search.

-

Misc: Huawei / Tencent выпустили обзор Embedding Compression in Recommender Systems: A Survey, а в Yahoo продолжают тюнить факторизационные машины Low Rank Field-Weighted Factorization Machines for Low Latency Item Recommendation.

Бизнес блог #1

Выжимаю книги до самой сути.

👉 Реклама - @jaMasha

📇 Хотите свою книгу? Мы напишем её за вас и сделаем книгу бестселлером. Подробности в боте @Summary_library_bot

🏆 Оставьте след в истории с помощью книги

https://expert-book.pro

Фильмы и сериалы со всей планеты. Мы знаем, что посмотреть, где посмотреть и на что сходить в кино.

Last updated 1 day, 8 hours ago

Все материалы размещены по партнёрской програме ivi.ru | All materials are posted on the partner program ivi.ru

По всем вопросам: @kuzr103

Купить рекламу: https://telega.in/c/k1noxa103

Основной канал: https://t.me/kino_hd2

Last updated 1 month, 2 weeks ago