black_samorez

Из России с любовью и улыбкой :)

From Russia with love and a smile :)

Chat - @ShutkaUm

@Shutka_U

Last updated 1 month, 2 weeks ago

Почистили канал, тут будут только реакты на ТВ шоу

Ожидаем ответа от ТВ

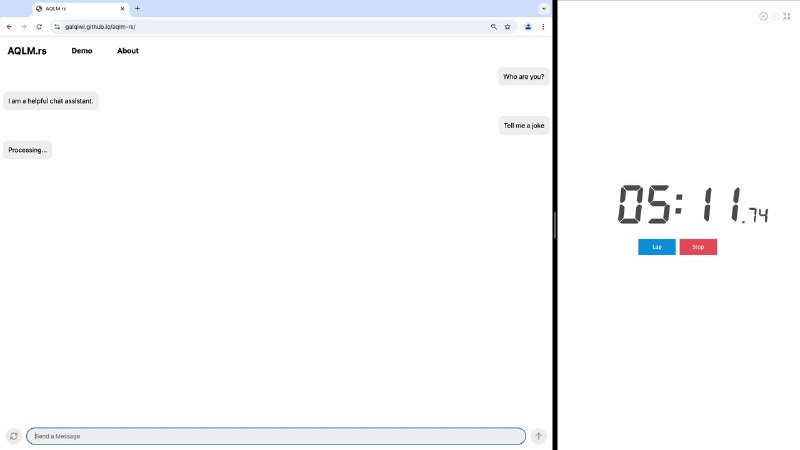

У меня есть несколько значительных апдейтов касательно AQLM:

Базовое качество: мы улучшили процедуру глобального файнтюна сетки квантизации, уменьшив зазор качества до FP16 на еще 10-30%. Мы обновили чекпоинты старых моделей и выложили еще несколько новых, включая gemma-2b.

Можно тюнить: мы прикрутили AQLM к PEFT, чтобы можно было тюнить LoRA поверх AQLM. Mixtral так можно тюнить в 15Gb VRAM хоть на колабе! (Colab Demo)

I am speed: мы добавили поддержку компиляции графа вычислений модели, что позволяет эффективно занулить оверхед питона при генерации, ускоряя ее в ~3 раза. (Colab Demo)

Из России с любовью и улыбкой :)

From Russia with love and a smile :)

Chat - @ShutkaUm

@Shutka_U

Last updated 1 month, 2 weeks ago

Почистили канал, тут будут только реакты на ТВ шоу

Ожидаем ответа от ТВ