黑洞资源笔记

Description

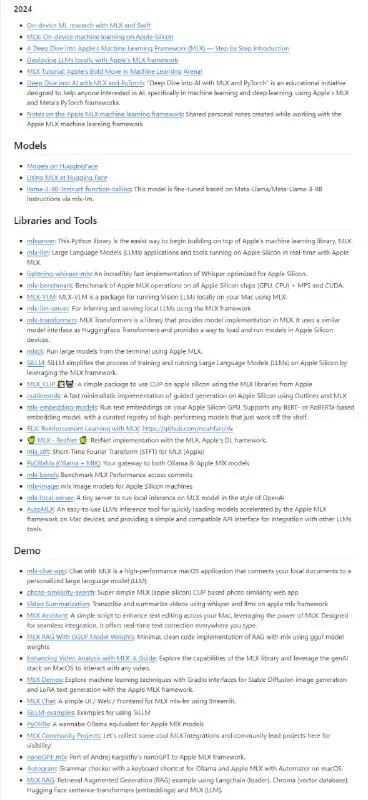

We recommend to visit

Last updated 2 years, 1 month ago

Last updated 2 years, 1 month ago

Last updated 1 year, 8 months ago

2 days, 3 hours ago

2 days, 16 hours ago

1 week, 2 days ago

用 ORPO 将 Llama 3 的性能提升到新高度 | 详文

ORPO(Odds Ratio Preference Optimization)是一种新的微调技术,可以将传统的监督微调和偏好对齐阶段合并为一个过程,从而减少计算资源和训练时间。

ORPO通过修改语言建模目标,将负对数似然损失与比值(OR)项相结合,以弱化被拒绝的响应并强化被选择的响应,让模型同时学习目标任务和人类偏好。

文章使用TRL库中的ORPOTrainer在Llama 3 8B模型上进行ORPO微调,数据集包含DPO偏好对,共1000个样本。尽管由于样本量少仅训练了1个epoch,但微调后的模型在Nous的基准测试中表现良好,所有指标上均优于Llama 3原模型。

ORPO展现了作为新的微调范式的潜力,未来在更大规模的偏好数据集上进行充分训练将产生更好的效果。选择高质量的数据集也非常重要。

当前是开源社区的活跃时期,正在发布越来越多高质量的开源模型,开源模型与专有模型的差距正在缩小,微调是获得最佳性能的关键。

1 week, 2 days ago

1 week, 2 days ago

| [#指南](?q=%23%E6%8C%87%E5%8D%97)](/media/attachments/pir/piracy6/26629.jpg)

Python 套件管理器——Poetry 完全入門指南 | #指南

2 weeks, 3 days ago

2 weeks, 3 days ago

2 weeks, 3 days ago

3 weeks, 4 days ago

: 基于 Triton 优化矩阵乘法运算的 Python 软件包,利用自定义内核实现高效性能](/media/attachments/pir/piracy6/26424.jpg)

BitMat: 基于 Triton 优化矩阵乘法运算的 Python 软件包,利用自定义内核实现高效性能

We recommend to visit

Last updated 2 years, 1 month ago

Last updated 2 years, 1 month ago

Last updated 1 year, 8 months ago

| [#素材](?q=%23%E7%B4%A0%E6%9D%90)](/media/attachments/pir/piracy6/26695.jpg)

](/media/attachments/pir/piracy6/26631.jpg)